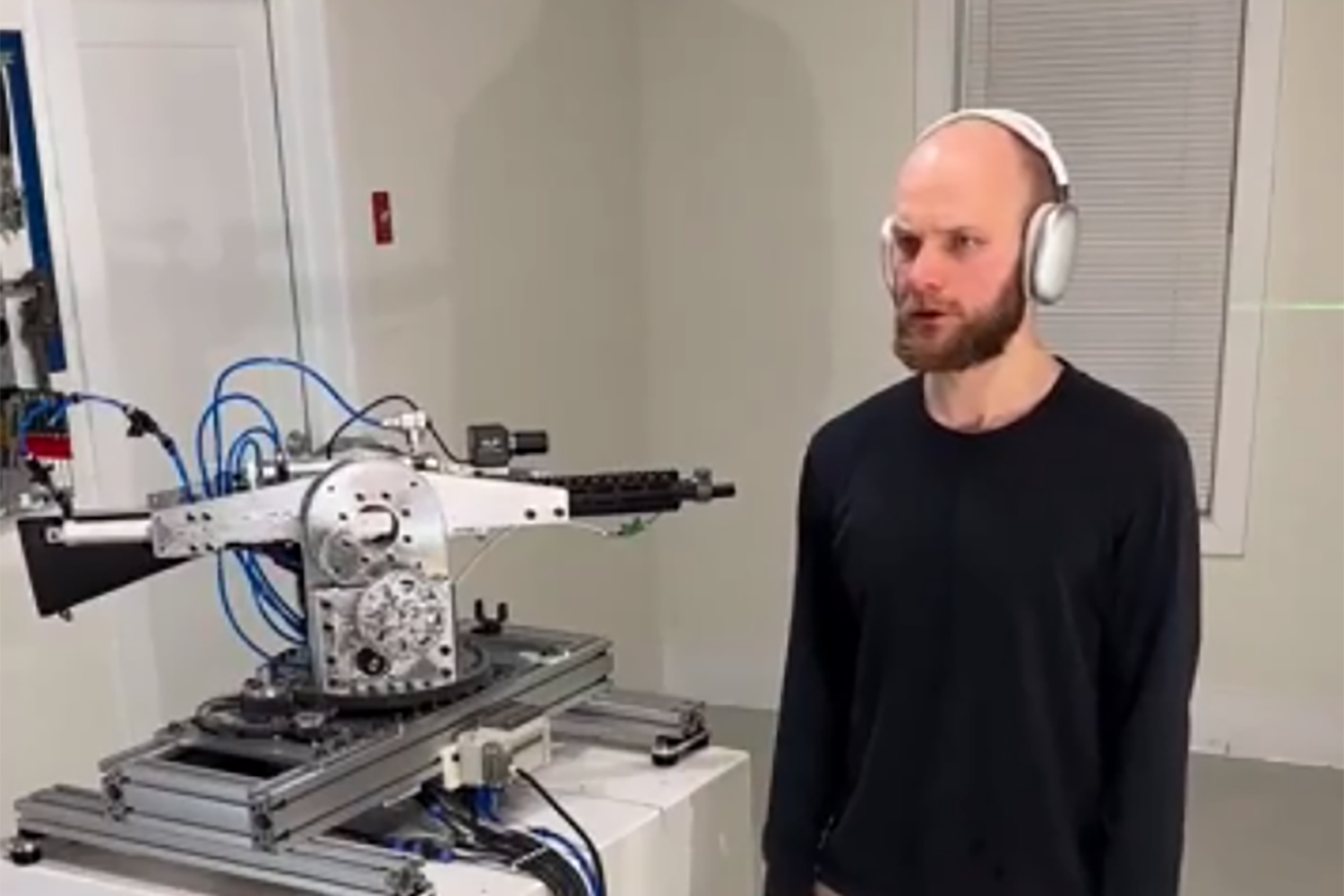

أوقفت OpenAI مطورًا قام ببناء جهاز يمكنه الاستجابة لاستفسارات ChatGPT بهدف توجيه وإطلاق بندقية آلية. أصبح الجهاز شائعًا بعد أن أظهر فيديو على Reddit مطوره وهو يقرأ أوامر إطلاق النار بصوت عالٍ، وبعد ذلك بدأت بندقية بجانبه بسرعة في التوجيه وإطلاق النار على الجدران القريبة.

“ChatGPT، نحن تحت هجوم من الجهة اليسرى الأمامية والجهة اليمنى الأمامية,” قال المطور للنظام في الفيديو. “استجب وفقًا لذلك.” السرعة والدقة التي تستجيب بها البندقية مثيرة للإعجاب، حيث تعتمد على واجهة OpenAI API في الوقت الحقيقي لتفسير المدخلات ثم إرجاع التوجيهات التي يمكن للجهاز فهمها. لن يتطلب الأمر سوى بعض التدريب البسيط لـ ChatGPT لاستقبال أمر مثل “توجه إلى اليسار” وفهم كيفية ترجمته إلى لغة يمكن للآلة قراءتها.

في بيان لـ Futurism، قالت OpenAI إنها شاهدت الفيديو وأوقفت المطور وراءه. “لقد حددنا بشكل استباقي هذا الانتهاك لسياساتنا وأبلغنا المطور بضرورة إيقاف هذا النشاط قبل تلقي استفسارك,” قالت الشركة للوسيلة الإعلامية. ربما كان المدير التنفيذي لـ OpenAI سام ألتمان محقًا في أن الذكاء الاصطناعي يمكن أن يدمّر الإنسانية. أو ربما تحتاج الأمور فقط إلى حواجز حماية مشابهة لكيفية رفض آلات النسخ لمسح الأموال الورقية.

إمكانية أتمتة الأسلحة الفتاكة هي واحدة من المخاوف التي أثارها المنتقدون حول تكنولوجيا الذكاء الاصطناعي مثل تلك التي طورتها OpenAI. نماذج الشركة متعددة الوسائط قادرة على تفسير المدخلات الصوتية والمرئية لفهم محيط الشخص والاستجابة للاستفسارات حول ما يرونه. تُطوَّر بالفعل طائرات مسيرة ذاتية يمكن استخدامها في ساحة المعركة لتحديد الأهداف وضربها دون الحاجة إلى تدخل بشري. هذا، بالطبع، يعد جريمة حرب، ويعرض البشر للخمول، مما يسمح للذكاء الاصطناعي باتخاذ القرارات ويجعل من الصعب محاسبة أي شخص.

لا يبدو أن القلق هو مجرد نظرية أيضًا. وجدت تقارير حديثة من واشنطن بوست أن إسرائيل قد استخدمت بالفعل الذكاء الاصطناعي لاختيار أهداف القصف، أحيانًا بشكل عشوائي. “جنود كانوا مدربين بشكل سيء على استخدام التكنولوجيا هاجموا أهدافًا بشرية دون التحقق من توقعات لافندر على الإطلاق,” تقول القصة، مشيرةً إلى قطعة من برامج الذكاء الاصطناعي. “في أوقات معينة، كانت المصداقية الوحيدة المطلوبة هي أن الهدف كان ذكراً.”

يقول مؤيدو الذكاء الاصطناعي في ساحة المعركة إنه سيجعل الجنود أكثر أمانًا من خلال السماح لهم بالبقاء بعيدًا عن الخطوط الأمامية وتحييد الأهداف، مثل مخازن الصواريخ، أو القيام بعمليات الاستطلاع من مسافة. ويمكن أن تضرب الطائرات المسيرة المدعومة بالذكاء الاصطناعي بدقة. لكن ذلك يعتمد على كيفية استخدامها. يقول النقاد إن الولايات المتحدة ينبغي أن تحسن من قدرتها على التشويش على أنظمة الاتصالات المعادية بدلاً من ذلك، حتى تواجه خصومًا مثل روسيا صعوبة أكبر في إطلاق طائراتهم المسيرة أو أسلحتهم النووية.

تحظر OpenAI استخدام منتجاتها لتطوير أو استخدام الأسلحة، أو “لأتمتة أنظمة معينة يمكن أن تؤثر على السلامة الشخصية.” لكن الشركة أعلنت العام الماضي عن شراكة مع شركة تكنولوجيا الدفاع Anduril، التي تصنع الطائرات المسيرة والصواريخ المدعومة بالذكاء الاصطناعي، لإنشاء أنظمة يمكنها الدفاع ضد هجمات الطائرات المسيرة. وتقول الشركة إنها ستقوم “بتوليف البيانات الحساسة زمنياً بسرعة، وتقليل العبء على المشغلين البشريين، وتحسين الوعي بالموقف.”

ليس من الصعب فهم سبب اهتمام شركات التكنولوجيا بالانتقال إلى الحرب. تنفق الولايات المتحدة ما يقرب من تريليون دولار سنويًا على الدفاع، ولا تزال فكرة تقليص هذا الإنفاق غير شعبية في الكونغرس. مع ملء الرئيس المنتخب ترامب وزارته بشخصيات تكنولوجية تميل نحو اليمين مثل إيلون ماسك وديفيد ساكس، من المتوقع أن تستفيد مجموعة كاملة من لاعبي تكنولوجيا الدفاع بشكل كبير وقد تحل محل شركات الدفاع الحالية مثل لوكهيد مارتن.

على الرغم من أن OpenAI تمنع عملائها من استخدام الذكاء الاصطناعي لبناء أسلحة، إلا أنه يوجد مجموعة كاملة من النماذج المفتوحة المصدر التي يمكن استخدامها لنفس الغرض. أضف إلى ذلك القدرة على طباعة أجزاء الأسلحة ثلاثية الأبعاد—وهي ما تعتقد قوات إنفاذ القانون أن المشتبه به في إطلاق النار من UnitedHealthcare لويجي مانجوني قد فعله—وأصبح من السهل بشكل صادم بناء آلات قتل ذاتية من راحة المنزل.